Cosa sono le curve AUC – ROC ?

Cos’è AUC-ROC

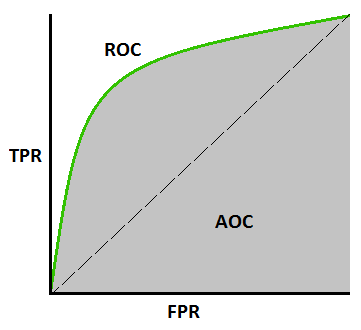

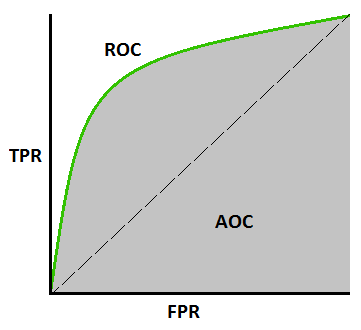

Iniziamo con una definizione formale: La “curva ROC” (Receiver Operating Characteristic curve) è una curva che mostra le prestazioni di un modello di classificazione a diverse soglie di probabilità. AUC è l’acronimo di (Area Under The Curve) e misura l’intera area bidimensionale sotto l’intera curva ROC da (0,0) a (1,1), in figura in grigio.

Prima di inoltrarci a capire cosa sia l’AUC-ROC e come tracciarla dobbiamo andare ad esaminare altre metriche che saranno utilizzate per tracciare la curva in questione.

In particolare dobbiamo capire e conoscere la metrica di Recall o TPR (True Positive Rate) o anche conosciuta come Sensitivity e la sua duale FPR (False Positive Rate) = 1 – Sensitivity.

Il grafico ROC si ottiene pertanto tracciando FPR e TPR sullo sistema di riferimento cartesiano, dove FPR (False Positive Rate) è tracciato sull’asse delle x e TPR (True Positive Rate) è tracciato sull’asse y per diversi valori di soglia di probabilità compresi tra 0,0 e 1,0.

In definitiva se noi andassimo ad effettuare dei test di inferenza sul nostro DATASET campione con l’obiettivo di calcolare il valore totale dei TPR e degli FPR al cambiare della soglia di valutazione su una classificazione binaria otterremmo la nostra AUROC.

Ricordiamoci che (vedi il mio precedente articolo):

La Recall indica quanto il sistema sia in grado di giudicare positivamente ( indica infatti la capacità di un sistema di trovare i possibili casi positivi nelle nostre migliori previsioni) e si esprime come rapporto tra i True Positive (risposte corrette) e la somma dei True Positive (risposte corrette) e dei False Negative ( risposte della rete ritenute negative quando in realtà sono positive) in altre parole :

si riferisce al rapporto tra le predizioni positive previste correttamente su tutte le etichette positive mentre :

si riferisce al rapporto tra le predizioni positive previste in modo errato su tutte le etichette negative.

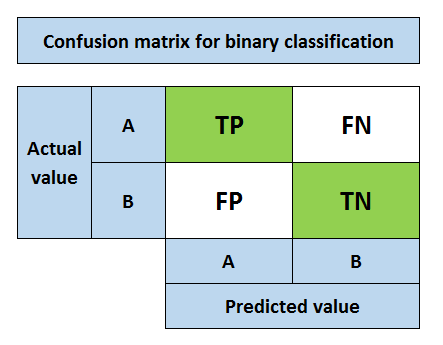

Cosa indicano FP, FN, TP, TN ?

- True Negative (TN) si verifica quando la previsione è 0 e la vera classe è effettivamente 0, cioè prevediamo correttamente che la classe è negativa (0).

- False Negative (FN) si verifica quando la previsione è 0 mentre la vera classe è in realtà 1, ovvero prevediamo erroneamente che la classe è negativa (0).

- False Positive (FP) si verifica quando la previsione è 1 mentre la vera classe è in realtà 0, ovvero prevediamo erroneamente che la classe è positiva (1).

- True Positive (TP) si verifica quando la previsione è 1 mentre la vera classe è in realtà 1, cioè prevediamo correttamente che la classe è positiva (1).

Un modo elegante per tracciare le metriche appena descritte ed avere una visione immediata della qualità del classificatore è quello di usare la matrice di confusione

Sono amante della tecnologia e delle tante sfumature del mondo IT, ho partecipato, sin dai primi anni di università ad importanti progetti in ambito Internet proseguendo, negli anni, allo startup, sviluppo e direzione di diverse aziende; Nei primi anni di carriera ho lavorato come consulente nel mondo dell’IT italiano, partecipando attivamente a progetti nazionali ed internazionali per realtà quali Ericsson, Telecom, Tin.it, Accenture, Tiscali, CNR. Dal 2010 mi occupo di startup mediante una delle mie società techintouch S.r.l che grazie alla collaborazione con la Digital Magics SpA, di cui sono Partner la Campania, mi occupo di supportare ed accelerare aziende del territorio .

Attualmente ricopro le cariche di :

– CTO MareGroup

– CTO Innoida

– Co-CEO in Techintouch s.r.l.

– Board member in StepFund GP SA

Manager ed imprenditore dal 2000 sono stato,

CEO e founder di Eclettica S.r.l. , Società specializzata in sviluppo software e System Integration

Partner per la Campania di Digital Magics S.p.A.

CTO e co-founder di Nexsoft S.p.A, società specializzata nella Consulenza di Servizi in ambito Informatico e sviluppo di soluzioni di System Integration, CTO della ITsys S.r.l. Società specializzata nella gestione di sistemi IT per la quale ho partecipato attivamente alla fase di startup.

Sognatore da sempre, curioso di novità ed alla ricerca di “nuovi mondi da esplorare“.

Comments