Come capire se la tua rete neurale soffre di problemi di overfitting o di underfitting

In questo post voglio riprendere un concetto di cui ho già parlato nell’articolo relativo all’overfitting di una rete neurale, in cui fornivo una spiegazione su cosa fossero i fenomeni di overfitting e di ‘underfitting, ma su cui non mi sono soffermato con esempi pratici.

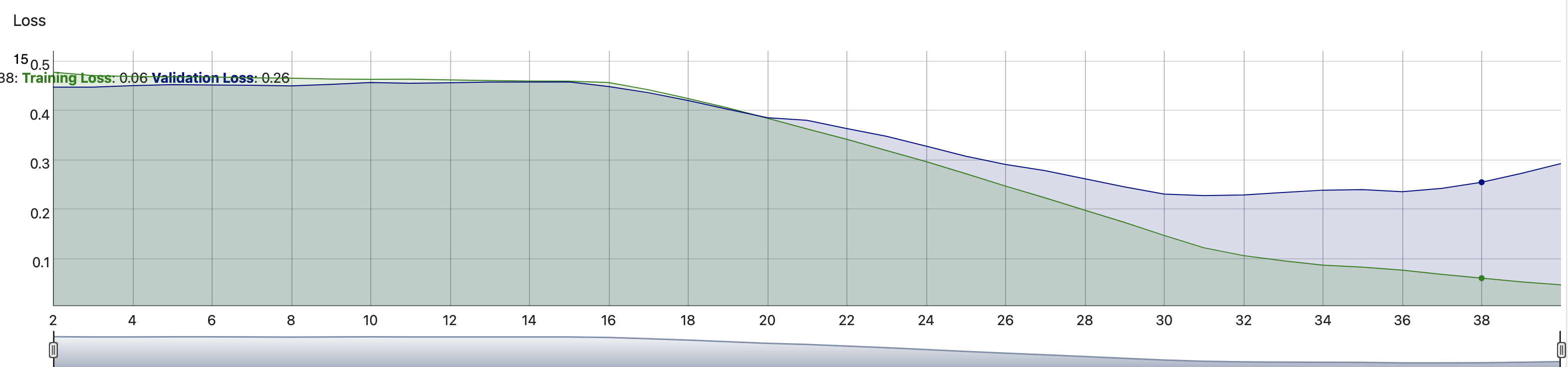

In questo breve post voglio riprendere lo stesso concetto andando ad analizzare le curve di loss di training e di validation, per dare un interpretazione al fenomeno.

Per comprendere la dinamica del fenomeno attraverso la lettura della curva di loss possiamo darci delle rigide regole e considerare che :

| Se la validation loss è molto maggiore della training loss possiamo dire che la rete soffre di problemi di overfitting.

Se la validation loss è maggiore della training loss possiamo dire che la rete probabilmente ha problemi di overfitting. Se la validation loss è minore della training loss possiamo dire che la rete probabilmente ha problemi di underfitting. Se la validation loss è molto minore della training loss possiamo dire che la rete soffre di problemi di underfitting. |

N.B.

La situazione perfetta si ottiene quando la validation loss e la training loss seguono un andamento simile, ma per una addestramento ideale la validation loss dovrà essere la più piccola possibile.

A questo punto risulterà chiaro osservando l’esempio della figura di cui sopra che la rete addestrata soffre di problemi di overfitting, ma ancora più grave emerge il problema relativo al valore finale della validation loss troppo elevato.

In tal caso si può indubbiamente concludere che la rete non risponderà adeguatamente alla fase di testing e che l’addestramento non è adeguato.

Sono amante della tecnologia e delle tante sfumature del mondo IT, ho partecipato, sin dai primi anni di università ad importanti progetti in ambito Internet proseguendo, negli anni, allo startup, sviluppo e direzione di diverse aziende; Nei primi anni di carriera ho lavorato come consulente nel mondo dell’IT italiano, partecipando attivamente a progetti nazionali ed internazionali per realtà quali Ericsson, Telecom, Tin.it, Accenture, Tiscali, CNR. Dal 2010 mi occupo di startup mediante una delle mie società techintouch S.r.l che grazie alla collaborazione con la Digital Magics SpA, di cui sono Partner la Campania, mi occupo di supportare ed accelerare aziende del territorio .

Attualmente ricopro le cariche di :

– CTO MareGroup

– CTO Innoida

– Co-CEO in Techintouch s.r.l.

– Board member in StepFund GP SA

Manager ed imprenditore dal 2000 sono stato,

CEO e founder di Eclettica S.r.l. , Società specializzata in sviluppo software e System Integration

Partner per la Campania di Digital Magics S.p.A.

CTO e co-founder di Nexsoft S.p.A, società specializzata nella Consulenza di Servizi in ambito Informatico e sviluppo di soluzioni di System Integration, CTO della ITsys S.r.l. Società specializzata nella gestione di sistemi IT per la quale ho partecipato attivamente alla fase di startup.

Sognatore da sempre, curioso di novità ed alla ricerca di “nuovi mondi da esplorare“.

Comments